Несмотря на то, что Национальная администрация безопасности дорожного движения (NHTSA) США расследовала противоречивый режим полуавтономного вождения Tesla, автопроизводитель не столкнулся ни с какими существенными последствиями. Новые и старые модели Tesla продолжают ездить по улицам и автомагистралям с технологией, которая — хотя технически является полуавтономным режимом движения по стандарту SAE Level 2 — может быть использована как полностью автономная система

Технология Autopilot от Tesla не соответствует своему названию

Противоречиво само название Autopilot, которое стало одной из причин многочисленных расследований деятельности компании Tesla со стороны федерального правительства и СМИ. В последнем расследовании Wall Street Journal (WSJ) журналисты пытались выяснить причины аварий Tesla, связанных с использованием автопилота

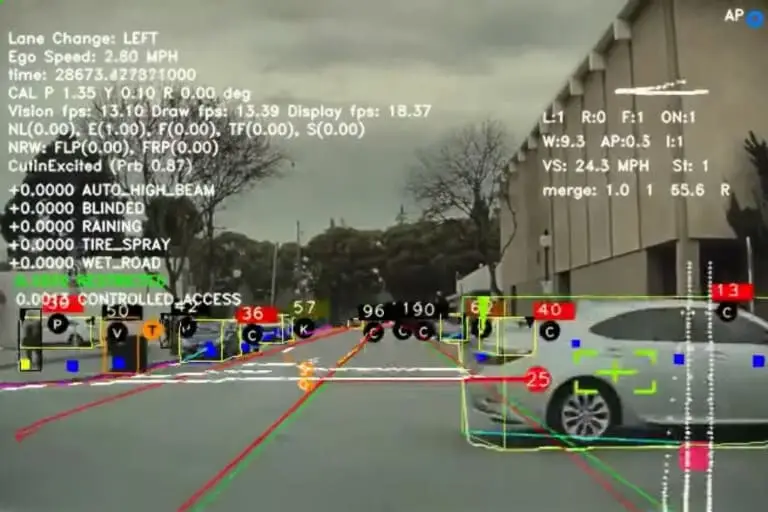

В 11-минутном видео WSJ, для просмотра которого требуется подписка, основные причины некоторых аварий связываются с чрезмерной зависимостью автопилота от компьютерного зрения, с помощью которого компьютер электромобиля обучается различать информацию, основанную на цифровых входных данных, таких как видео

NHTSA сообщило о 1000 аварий Tesla

Автопроизводители в США обязаны сообщать обо всех серьезных авариях с участием автоматизированных систем вождения SAE уровня 2 или выше, поскольку в июне 2021 года NHTSA издала общий приказ об отчетности об авариях. Как сообщается, с 2016 года Tesla подала в NHTSA более 1000 отчетов об авариях, но WSJ утверждает, что большая часть этих данных скрыта от общественности, поскольку Tesla считает их коммерческой тайной. Однако журналистам издания удалось обойти эту проблему, они собрали отчеты из отдельных штатов и сделали перекрестные ссылки на данные об авариях, которые Tesla подала в NHTSA

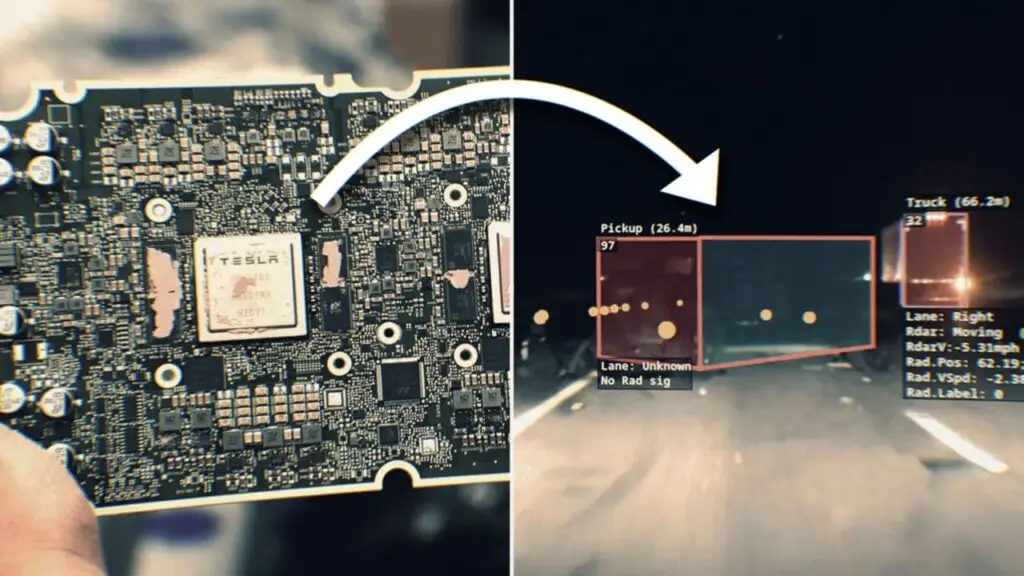

Среди 222 аварий, которые WSJ собрала для этого отчета, 44 произошли, когда Tesla с включенным автопилотом внезапно свернула в сторону, а еще 31 авария произошла, когда автопилот не смог съехать с дороги или остановиться перед препятствием. Говорят, что инциденты, когда Tesla не смогла остановиться, приводят к самым серьезным травмам или смерти. WSJ попросила экспертов проанализировать одну смертельную аварию, в которой автопилот не распознал опрокинутый грузовик на шоссе, и автомобиль врезался в него

Использование компьютерных сенсоров и камер, вместо лидаров, является одной из причин отказа автопилота и аварий Tesla

Именно это, по мнению некоторых экспертов, опрошенных журналом, свидетельствует о самом серьезном недостатке «Автопилота». В отличие от некоторых других автопроизводителей, которые используют радарное компьютерное зрение и лазер LiDAR для обнаружения объектов, электрическая машина Tesla в основном полагается на компьютерное зрение на основе видео камер с радаром

Джон Бернал, которого уволили из Tesla в 2022 году за то, что он обнародовал видео с отказом автопилота, рассказал WSJ об обнаружении проблем с камеры, которые используются на некоторых моделях Tesla. Дело в том, что они не откалиброваны должным образом, а когда камеры не видят одно и то же, то возникает проблема с идентификацией препятствий. И, как предполагают в расследовании, чрезмерная зависимость Tesla от камер для контроля автопилота и может привести к авариям

В свою очередь, Tesla утверждает, что благодаря ее автопилоту аварийность снижается в 8 раз

Читать дальше

Похожие записиЧитать дальше

Последние новости, которые могут вас заинтересовать

-

Корея запретит заряжать электромобили до 100%

Власти Сеула настолько обеспокоены риском возгорания электромобилей, что готовят новые правила, которые не позволят заезжать в подземные паркинги электромобилям с зарядом батареи более 90% В начале августа Mercedes-Benz EQE вспыхнул в подземном гараже жилого комплекса, вызвав пожар, который повредил 880 припаркованных рядом автомобилей и оставил 1600 домохозяйств без электричества и воды на неделю. Чтобы избежать […]

23 августа 2024 -

Первые Volvo EX90 временно не будут иметь некоторых функций, анонсированных ранее

В начале прошлого месяца Volvo наконец-то начала производство EX90, пообещав доставить его клиентам во второй половине 2024 года. Автопроизводителю пришлось отложить запуск электромобиля, чтобы решить некоторые проблемы с программным обеспечением Чего будут лишены лучшие полноприводные кроссоверы Volvo? Один из первых клиентов поделился электронным письмом, полученным от Volvo, со ссылкой на список функций, «которые могут […]

8 июля 2024 -

Mercedes готовит более 40 новых электромобилей к 2027 году

Mercedes-Benz вступает в новую фазу развития, которая может изменить будущее компании Производитель премиумкласса готовит масштабное обновление модельного ряда и планирует выпустить более 40 новых автомобилей всего за три года. Речь идет не только об очередных моделях, а о самом масштабном продуктовом наступлении во всей истории бренда Чтобы реализовать этот амбициозный план, Mercedes инвестировал более двух […]

11 сентября 2025