Автономні автомобілі вже давно вийшли за межі наукової фантастики та стали частиною реального світу, де вони обіцяють революцію в транспорті, зменшуючи кількість аварій, спричинених людським фактором, і полегшуючи життя мільйонам людей. Однак тиск на ці технології величезний, бо кожна помилка не тільки підриває довіру суспільства, а й змушує виробників інвестувати мільярди в удосконалення

У дослідженні, опублікованому в жовтневому номері журналу IEEE Transactions on Intelligent Transportation Systems за 2025 рік, вчені детально розглянули, коли моделям AI ставлять конкретні запитання для розкриття їхнього процесу мислення, як пояснювальний штучний інтелект допомагає точно локалізувати помилки в системах автономних транспортних засобів. Такий метод не обмежується лише допомогою пасажирам у моменти, коли потрібно втрутитися, а й сприяє загальному зміцненню довіри до технологій, дозволяючи інженерам створювати надійніші моделі, адаптовані до реальних дорожніх умов

Шагін Атакішієв, фахівець із глибокого навчання, який працював над цим проєктом під час постдокторської програми в Університеті Альберти в Канаді, підкреслює непрозорість типової архітектури автономного водіння. Звичайні люди, від пасажирів до пішоходів, часто не розуміють як транспортний засіб обробляє дані в реальному часі та обирає дії, на кшталт повороту чи зупинки. У 2025 році, коли автономні системи вже тестуються в багатьох містах, наприклад, Сан-Франциско компанією Waymo чи в Європі Mercedes-Benz, ця проблема стає ще актуальнішою, бо регулятори, як-от NHTSA в США, вимагають більшої прозорості для сертифікації

Прогрес у штучному інтелекті дозволяє тепер безпосередньо запитувати моделі про причини їхніх рішень, відкриваючи двері для глибокого аналізу

Наприклад, можна з’ясувати, на які елементи візуальної інформації з камер чи lidar модель акцентувала увагу під час раптового гальмування, або як часові фактори, на кшталт швидкості обробки даних, вплинули на вибір траєкторії. У контексті 2025 року, коли генеративний AI інтегрується в системи на кшталт NVIDIA Drive Orin, такі запитання допомагають виявляти вразливості до хакерських атак чи помилок у розпізнаванні об’єктів у погану погоду

У статті Атакішієва та його команди наводиться приклад зворотного зв’язку в реальному часі, який може врятувати від аварій

Вони згадують експеримент іншої групи, де знак обмеження швидкості 35 миль на годину (56 км/год) трохи модифікували наклейкою, подовживши середню частину “3”, і перевірили реакцію Tesla Model S. Дисплей автомобіля помилково прочитав знак як 85 миль на годину (137 км/год), через що машина прискорилася. Сьогодні, у 2025 році, подібні інциденти з Tesla’s Full Self-Driving (FSD) версії 12.5 призводять до розслідувань, і генеративний AI міг би виправити ситуацію, надаючи обґрунтування на екрані, на кшталт “Виявлено обмеження 85 миль, прискорююся”, аби пасажир вчасно відреагував

Виклик полягає в адаптації рівня деталізації пояснень під індивідуальні потреби, бо хтось віддасть перевагу аудіо-повідомленню, а хтось візуалізації чи текстовому опису, залежно від віку, технічного досвіду чи когнітивних особливостей. У сучасних проєктах, як-от у Cruise від GM, тестують мультимодальні інтерфейси, де вібрація керма сигналізує про потенційну помилку, поєднуючи з голосом для літніх користувачів

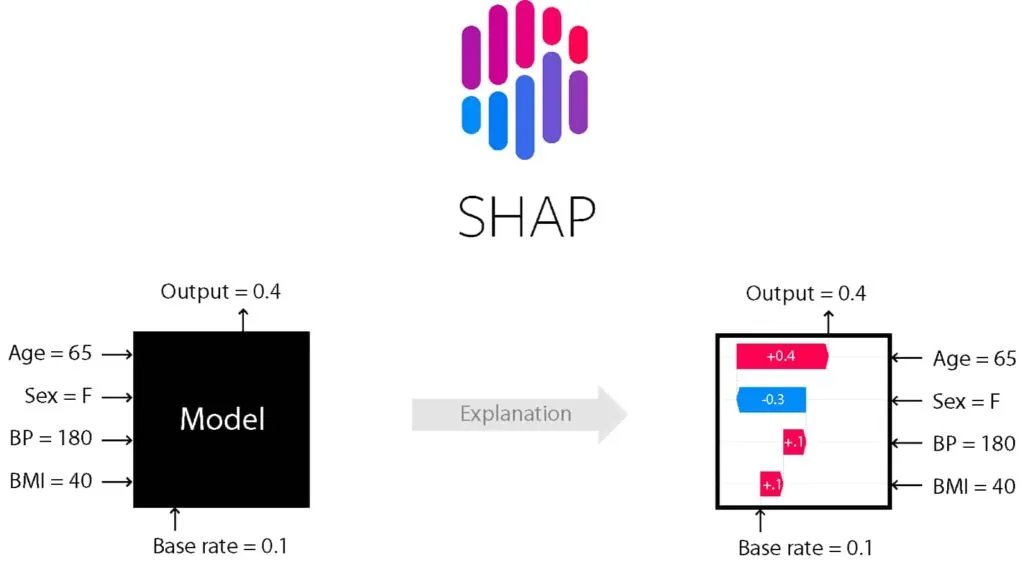

Аналіз рішень після помилки відкриває шлях до вдосконалення, бо симуляції в дослідженні Атакішієва виявили слабкі місця через хитрі запитання, які модель не змогла пояснити. Це нагадує реальні випадки, як аварія Uber у 2018 році, де XAI міг би запобігти подібному в майбутньому. Техніка SHapley Additive exPlanations (SHAP) стає інструментом для оцінки впливу кожної характеристики після поїздки, дозволяючи оптимізувати моделі, відкидаючи непотрібні дані та фокусуючись на критичних, на кшталт розпізнавання пішоходів

Юридичні аспекти аварій з пішоходами також розкриваються через пояснення: чи дотримувалася машина правил, чи зупинилася після удару, чи активувала екстрені служби? У 2025 році, з новими регуляціями ЄС щодо AI Act, такі запитання стають обов’язковими для виробників, аби уникнути штрафів. Пояснювальний AI набирає обертів, інтегруючись у системи компаній Mobileye, і обіцяє безпечніші дороги, зменшуючи аварії на 94%, спричинені людськими помилками, за даними WHO

У ширшому сенсі XAI вже працює разом із великими мовними моделями

Прикладом може бути Wayve LINGO-2, де штучний інтелект пояснює свої дії звичайними словами, на кшталт «Дорога порожня, рухаюсь далі». У дослідженнях Nature за 2025 рік підкреслюється важливість пояснень у режимі реального часу для мереж автономних авто у розумних містах. Там AI не лише прогнозує дорожню ситуацію, а й пояснює свої рішення, щоб зробити рух ефективнішим. Попри прогрес, залишаються проблеми. Великі мовні моделі іноді вигадують факти, тому потрібна перевірка їхніх відповідей, а системи автономних авто мають бути захищені від кібер атак, як показали нещодавні випробування на Tesla

Таблиця ілюструє різноманітність методів, які роблять AI прозорішим, і підкреслює їхню роль у еволюції автономного водіння. Загалом, штучний інтелект не тільки рятує життя, а й формує майбутнє мобільності, де машини та люди співіснують гармонійно

| Метод XAI | Застосування в AV | Переваги | Недоліки | Приклади |

| Візуальні пояснення (Grad-CAM, Saliency Maps) | Розпізнавання об’єктів, сцен | Показує фокус уваги | Обмежена глибина | Tesla FSD, BDD100K датасет |

| RL/IL-based | Планування траєкторії | Інтерпретує дії в динаміці | Складність обчислень | CARLA симулятор, Waymo |

| Decision Tree | Верфікація цілей | Прозорість логіки | Менша точність у складних сценах | OGRIT для оклюзій |

| Logic-Based | Формальна перевірка | Юридична відстежуваність | Абстрактність | ASP з YOLOv3 |

| LLM/VLM | Природні пояснення | Людський інтерфейс | Галюцинації | LINGO-1, DriveGPT4 |

| SHAP | Пост-аналіз факторів | Оптимізація моделі | Часозатратність | Після поїздки в Tesla |

| Користувацькі студії | HMI оптимізація | Зростання довіри | Суб’єктивність | Multimodal feedback в CarMaker |

Читати далі

Схожі записиЧитати далі

Останні новини, що можуть вас зацікавити

-

Volvo EX30 тепер європейський: старт виробництва у Бельгії вирішує тарифні проблеми електрохіта

Донедавна компактні електричні кросовери Volvo EX30 сходили лише з конвеєра заводу Geely Group у Китаї, наражаючись на значні імпортні мита. Тепер ситуація змінюється – виробництво стартувало в серці Європи Виробничі лінії Volvo EX30 запрацювали на повну потужність у бельгійському Генті. Цей крок став вимушеним прискоренням планів Volvo через тарифну перехресну стрілянину між Китаєм, Європою та […]

29 Квітня 2025 -

Чому Porsche та Volvo скорочують тисячі робочих місць?

Уповільнення темпів впровадження електромобілів, загострення торгівельних суперечок та загальна економічна нестабільність змушують компанії переглядати свої стратегії. Volkswagen, свого часу, задав тон, анонсувавши скорочення понад 35 000 робочих місць до 2030 року. Тепер естафету перейняли Porsche та Volvo, оголосивши про спільне скорочення близько 6900 позицій по всьому світу Porsche: між електрифікацією та ринковою реальністю Для […]

27 Травня 2025 -

BYD здивувала Японію своїм крихітним електромобілем

Racco став першим представником BYD у популярному японському класі kei car — надкомпактних міських авто, що користуються шаленою популярністю завдяки своїй зручності, економічності та спеціальним податковим пільгам. Довжина новинки становить лише 3395 мм, ширина — 1475 мм, висота — 1800 мм, тобто вона повністю відповідає жорстким японським нормам для цього класу На перший погляд, дизайн […]

31 Жовтня 2025