Незважаючи на те, що Національна адміністрація безпеки дорожнього руху (NHTSA) США розслідувала суперечливий режим напівавтономного водіння Tesla, автовиробник не зіткнувся з жодними суттєвими наслідками. Нові та старі моделі Tesla продовжують їздити вулицями та автомагістралями з технологією, яка – хоча технічно є напівавтономним режимом руху за стандартом SAE Level 2 – може бути використана як повністю автономна система

Технологія Autopilot від Tesla не відповідає своїй назві

Суперечлива сама назва Autopilot, яка стала однією з причин численних розслідувань діяльності компанії Tesla з боку федерального уряду та ЗМІ. В останньому розслідуванні Wall Street Journal (WSJ) журналісти намагалися з’ясувати причини аварій Tesla, пов’язаних з використанням автопілоту

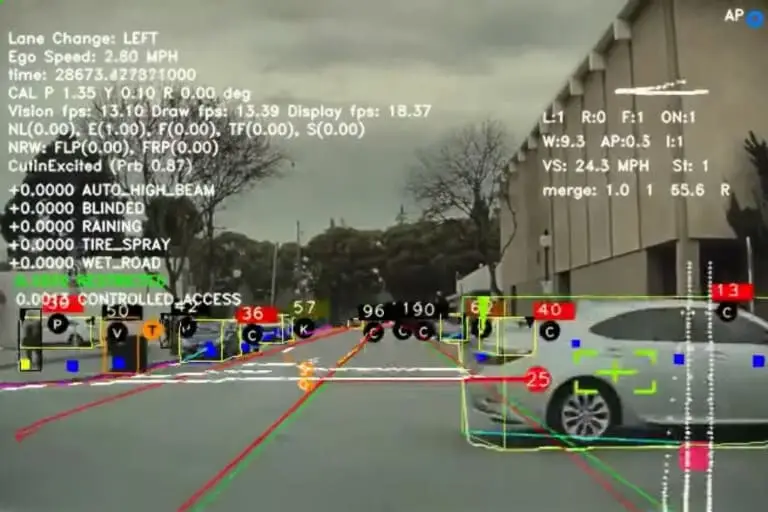

У 11-хвилинному відео WSJ, для перегляду якого потрібна підписка, основні причини деяких аварій пов’язуються з надмірною залежністю автопілота від комп’ютерного зору, за допомогою якого комп’ютер електромобіля навчається розрізняти інформацію, засновану на цифрових вхідних даних, таких як відео

NHTSA повідомило про 1000 аварій Tesla

Автовиробники в США зобов’язані повідомляти про всі серйозні аварії за участю автоматизованих систем водіння SAE рівня 2 або вище, оскільки в червні 2021 року NHTSA видала загальний наказ про звітність про аварії. Як повідомляється, з 2016 року Tesla подала до NHTSA понад 1000 звітів про аварії, але WSJ стверджує, що більша частина цих даних прихована від громадськості, оскільки Tesla вважає їх комерційною таємницею. Однак журналістам видання вдалося обійти цю проблему, вони зібрали звіти з окремих штатів і зробили перехресні посилання на дані про аварії, які Tesla подала до NHTSA

Серед 222 аварій, які WSJ зібрала для цього звіту, 44 сталися, коли Tesla з увімкненим автопілотом раптово звернула вбік, а ще 31 аварія сталася, коли автопілот не зміг з’їхати з дороги або зупинитися перед перешкодою. Кажуть, що інциденти, коли Tesla не змогла зупинитися, призводять до найсерйозніших травм або смерті. WSJ попросила експертів проаналізувати одну смертельну аварію, в якій автопілот не розпізнав перекинуту вантажівку на шосе, і автомобіль врізався в неї

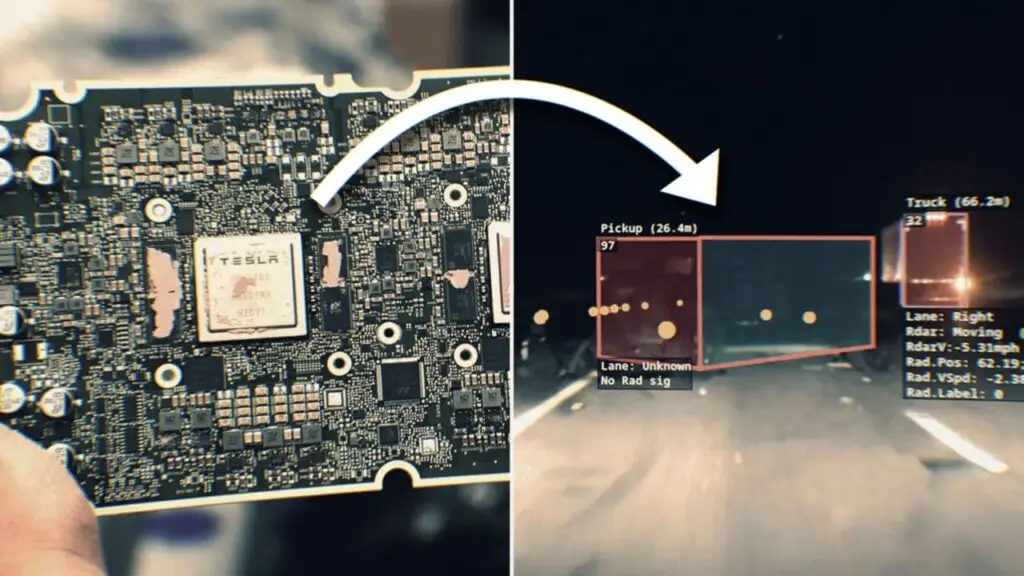

Використання комп’ютерних сенсорів і камер, замість лідарів, є однією з причин відмови автопілоту та аварій Tesla

Саме це, на думку деяких експертів, опитаних журналом, свідчить про найсерйозніший недолік «Автопілота». На відміну від деяких інших автовиробників, які використовують радарний комп’ютерний зір і лазер LiDAR для виявлення об’єктів, машина на електриці від Tesla в основному покладається на комп’ютерний зір на основі відео камер з радаром

Джон Бернал, якого звільнили з Tesla у 2022 році за те, що він оприлюднив відео з відмовою автопілоту, розповів WSJ про виявлення проблем з камери, які використовуються на деяких моделях Tesla. Справа в тому, що вони не відкалібровані належним чином, а коли камери не бачать одне й те саме, то виникає проблема з ідентифікацією перешкод. І, як припускають в розслідуванні, надмірна залежність Tesla від камер для контролю автопілота і може призвести до аварій

В свою чергу, Tesla стверджує, що завдяки її автопілоту аварійність знижується у 8 разів

Читати далі

Схожі записиЧитати далі

Останні новини, що можуть вас зацікавити

-

За прогнозами ринок електромобілів в 2025 році зросте на 30%

Експерти S&P Global Mobility прогнозують, що наступного року продажі електромобілів на акумуляторах сягнуть 15,1 мільйона одиниць, що збільшить їхню частку на ринку до 16,7 відсотка світових продажів автомобілів. Хоча остаточні цифри на 2024 рік ще не відомі, за оцінками, продажі складуть 11,6 мільйона електромобілів, що дасть їм 13,2 відсотка частки ринку Індія зростатиме, але США […]

31 Грудня 2024 -

Дилери Honda розлючені через Afeela, але бренд це не хвилює

Honda усе активніше робить ставку на електромобілі, і напруга всередині її власної дилерської мережі стрімко зростає. Американські дилери Honda відкрито виступають проти спільного електромобільного проєкту з Sony, вважаючи, що він відтягує на себе фінанси, управлінську увагу та інженерні ресурси, які мали б іти на розвиток ключових моделей Honda та Acura. Особливо болісно це сприймається на […]

15 Січня 2026 -

Дебютував DS N°8 – флагманський електромобіль від DS Automobiles

DS Automobiles, французький преміум-бренд корпорації Stellantis, презентував DS N°8 — повністю електричний кросовер-купе, який обіцяє стати достойним суперником у класі люксових електромобілів. Новинка є першою моделлю бренду, створеною на платформі STLA Medium, і демонструє свіжий підхід до дизайну, технологій та екологічності Інноваційний дизайн і технічні рішення Зовнішній вигляд DS N°8 запозичує елементи концепту DS Aero […]

14 Грудня 2024