Автономные автомобили уже давно вышли за пределы научной фантастики и стали частью реального мира, где они обещают революцию в транспорте, уменьшая количество аварий, вызванных человеческим фактором, и облегчая жизнь миллионам людей. Однако давление на эти технологии огромно, потому что каждая ошибка не только подрывает доверие общества, но и заставляет производителей инвестировать миллиарды в усовершенствование

В исследовании, опубликованном в октябрьском номере журнала IEEE Transactions on Intelligent Transportation Systems за 2025 год, ученые подробно рассмотрели, когда моделям AI задают конкретные вопросы для раскрытия их мышления, как объяснительный искусственный интеллект помогает точно локализовать ошибки в системах автономных транспортов. Такой метод не ограничивается не только помощью пассажирам в моменты, когда нужно вмешаться, но и способствует общему укреплению доверия к технологиям, позволяя инженерам создавать более надежные модели, адаптированные к реальным дорожным условиям

Шагин Атакишиев, специалист по глубокому обучению, работавший над этим проектом во время постдокторской программы в Университете Альберты в Канаде, подчеркивает непрозрачность типовой архитектуры автономного вождения. Обычные люди, от пассажиров до пешеходов, часто не понимают, как транспортное средство обрабатывает данные в реальном времени и выбирает действия, вроде поворота или остановки. В 2025 году, когда автономные системы уже тестируются во многих городах, например, Сан-Франциско компанией Waymo или в Европе Mercedes-Benz, эта проблема становится еще более актуальной, так как регуляторы, такие как NHTSA в США, требуют большей прозрачности для сертификации

Прогресс в искусственном интеллекте позволяет теперь напрямую спрашивать модели о причинах их решений, открывая двери для глубокого анализа

Например, можно выяснить, на какие элементы визуальной информации с камер или lidar модель акцентировала внимание во время внезапного торможения или как временные факторы, вроде скорости обработки данных, повлияли на выбор траектории. В контексте 2025 года, когда генеративный AI интегрируется в системы типа NVIDIA Drive Orin, такие вопросы помогают проявлять уязвимости к хакерским атакам или ошибкам в распознавании объектов в плохую погоду

В статье Атакишиева и его команды приводится пример обратной связи в реальном времени, которое может спасти от аварий

Они вспоминают эксперимент другой группы, где знак ограничения скорости 35 миль в час (56 км/ч) немного модифицировали наклейкой, удлинив среднюю часть «3», и проверили реакцию Tesla Model S. Дисплей автомобиля по ошибке прочитал знак как 85 миль в час (137 км/ч), из-за чего машина ускорилась. Сегодня, в 2025 году, подобные инциденты с Tesla’s Full Self-Driving (FSD) версии 12.5 приводят к расследованиям, и генеративный AI мог бы исправить ситуацию, предоставляя обоснование на экране, вроде «Обнаружено ограничение 85 миль, ускоряюсь»

Вызов заключается в адаптации уровня детализации пояснений под индивидуальные потребности, потому что кто предпочтет аудио-сообщение, а кто визуализации или текстового описания, в зависимости от возраста, технического опыта или когнитивных особенностей. В современных проектах, таких как Cruise от GM, тестируют мультимодальные интерфейсы, где вибрация руля сигнализирует о потенциальной ошибке, сочетая с голосом для пожилых пользователей

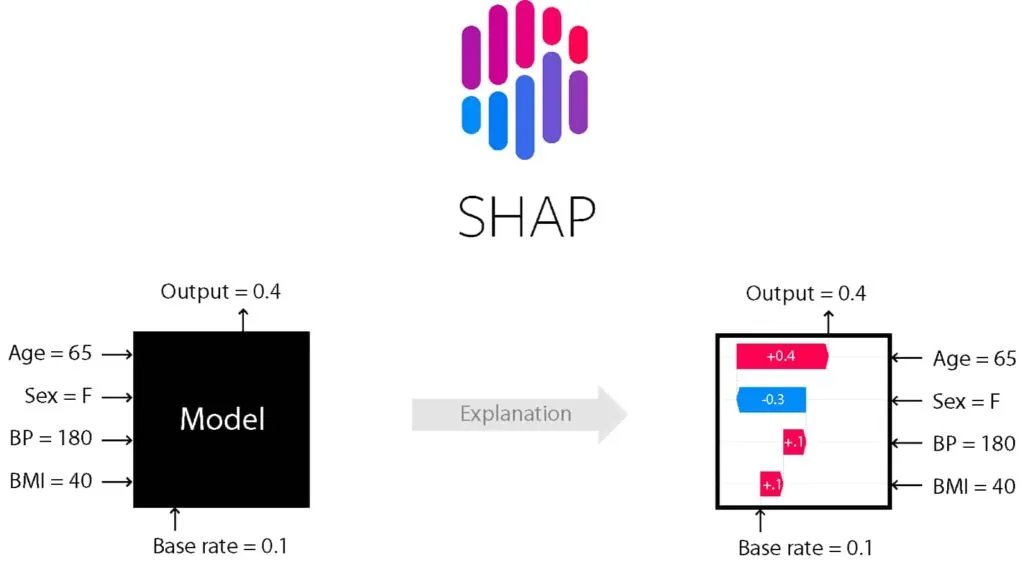

Анализ решений после ошибки открывает путь к совершенствованию, потому что симуляции в исследовании Атакишиева обнаружили слабые места из-за хитрых вопросов, которые модель не смогла объяснить. Это напоминает реальные случаи, как авария Uber в 2018 году, где XAI мог бы предотвратить подобное в будущем. Техника SHapley Additive exPlanations (SHAP) становится инструментом для оценки влияния каждой характеристики после поездки, позволяя оптимизировать модели, отбрасывая ненужные данные и фокусируясь на критических, вроде распознавания пешеходов

Юридические аспекты аварий с пешеходами также раскрываются из-за объяснений: соблюдалась ли машина правил, остановилась ли после удара или активировала экстренные службы? В 2025 году, с новыми регуляциями ЕС по AI Act, такие вопросы становятся обязательными для производителей во избежание штрафов. Объяснительный AI набирает обороты, интегрируясь в системы компаний Mobileye, и обещает более безопасные дороги, уменьшая аварии на 94%, вызванные человеческими ошибками, по данным WHO

В более широком смысле XAI уже работает вместе с большими языковыми моделями

Примером может служить Wayve LINGO-2, где искусственный интеллект объясняет свои действия обычными словами, вроде «Дорогая пустая, двигаюсь дальше». В исследованиях Nature за 2025 год подчеркивается важность пояснений в режиме реального времени для сетей автономных автомобилей в умных городах. Там AI не только прогнозирует дорожную ситуацию, но и объясняет свои решения, чтобы сделать движение более эффективным. Несмотря на прогресс, остаются проблемы. Большие языковые модели иногда придумывают факты, поэтому требуется проверка их ответов, а системы автономных автомобилей должны быть защищены от кибер атак, как показали недавние испытания на Tesla

Таблица иллюстрирует разнообразие методов, которые делают AI более прозрачными, и подчеркивает их роль в эволюции автономного вождения. В общем, искусственный интеллект не только спасает жизнь, но и формирует будущее мобильности, где машины и люди гармонично сосуществуют

| Метод XAI | Применение в AV | Преимущества | Недостатки | Примеры |

| Визуальные пояснения (Grad-CAM, Saliency Maps) | Распознавание объектов, сцен | Показывает фокус внимания | Ограниченная глубина | Tesla FSD, BDD100K датасет |

| RL/IL-based | Планирование траектории | Интерпретирует действия в динамике | Сложность вычислений | CARLA симулятор, Waymo |

| Decision Tree | Верфикация целей | Прозрачность логики | Меньшая точность в сложных сценах | OGRIT для окклюзий |

| Logic-Based | Формальная проверка | Юридическая отслеживаемость | Абстрактность | ASP з YOLOv3 |

| LLM/VLM | Естественные объяснения | Человеческий интерфейс | Галлюцинации | LINGO-1, DriveGPT4 |

| SHAP | Пост-анализ факторов | Оптимизация модели | Временная затратность | После поездки в Tesla |

| Пользовательские студии | HMI оптимизация | Рост доверия | Субъективность | Multimodal feedback в CarMaker |

Читать дальше

Похожие записиЧитать дальше

Последние новости, которые могут вас заинтересовать

-

Genesis Neolun — будущий флагманский кроссовер

Одним из последних пробелов в линейке Genesis был большой внедорожник. Среди череды дебютов Genesis в Нью-Йорке — концепт Neolun. Это большой, флагманский роскошный кроссовер, который не только показывает каким будет серийная модель, но и намекает на то, куда движется дизайн Genesis Примитивный экстерьер состоит из двух-объемного кузова внедорожника и чистых панелей. Единственными выразительными деталями являются […]

27 марта 2024 -

Tesla до сих пор принимает $50 000 за Roadster, который Илон Маск пообещал еще в 2017 году

В мире, где время — это деньги, компания Tesla, похоже, решила, что деньги можно брать даже без привязки ко времени. Речь идет о втором поколении Tesla Roadster — спортивного электрокара, который Илон Маск представил еще в ноябре 2017 года. Прошло почти восемь лет, а Tesla до сих пор с удовольствием принимает $50 000 за резервирование […]

25 марта 2025 -

Китай укрепляет лидерство на рынке электромобилей

Китай достиг значительных успехов в развитии электромобильной индустрии, опережая США и Европу. Данные свидетельствуют, что страна занимает лидирующую позицию в глобальных продажах электромобилей (EV) и гибридов с подзарядкой (PHEV). В октябре доля Китая на мировом рынке составила 76%, что является беспрецедентным показателем Между январем и октябрем 2024 года Китай отвечал за 69% продаж электромобилей и […]

6 декабря 2024